硅基流动(SiliconCloud)正式上线了全球首个开源的大规模混合注意力推理模型 ——MiniMax-M1-80k(456B)。这一创新模型旨在为软件工程、长上下文理解和工具使用等复杂任务提供强有力的支持,并且在性能上可与目前顶尖的模型如 o3和 Claude4Opus 相媲美。

据悉,MiniMax-M1-80k 具备最大支持128K 的上下文长度,这为处理长文本提供了极大的便利。对于有特殊需求的用户,平台还提供了后台支持,满足1M 的长上下文需求。使用该模型的价格为输入 ¥4每百万 Tokens,输出则为 ¥16每百万 Tokens。新用户在首次使用时还能享受到14元的体验赠金。

MiniMax-M1-80k 模型的研发基于 MiniMax-Text-01,采用了混合专家系统(MoE)架构和 Lightning Attention 机制,具备高效的强化学习扩展框架。这一设计使得模型不仅适用于传统的数学推理任务,还能够在真实的沙盒软件开发环境中发挥作用。因此,它成为了需要长文本处理与深度思考任务的理想选择。

在性能方面,MiniMax 的基准测试显示,该模型在生成10万 Tokens 时,FLOPs 消耗仅为 DeepSeek R1的25%,这意味着其推理算力的高效扩展。同时,MiniMax-M1-80k 在数学、编程、工具使用及长上下文理解等领域的评测结果都与 o3等顶尖模型不相上下。

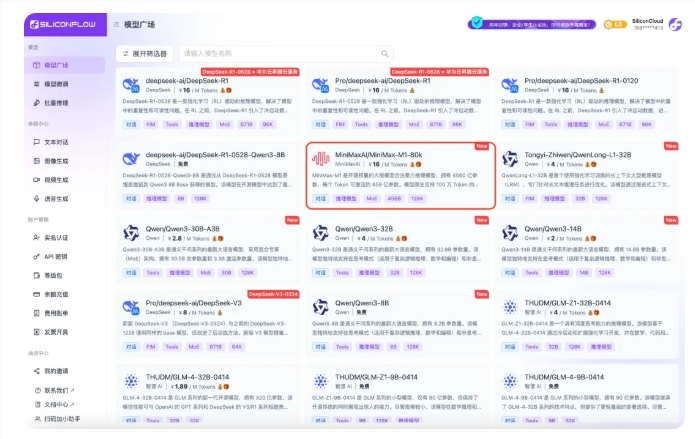

SiliconCloud 作为一站式的大模型云服务平台,致力于为开发者提供优质的服务。除了 MiniMax-M1-80k,平台上还推出了多款优秀的模型,包括 DeepSeek-R1-0528、Qwen3、GLM-4系列等,极大丰富了开发者的选择。特别是 DeepSeek-R1的蒸馏版及其他多款模型均可免费使用,助力开发者实现 “Token 自由”。

如需体验新上线的 MiniMax-M1-80k,用户可通过 SiliconCloud 官方网站进行在线体验和接入,进一步推动生成式 AI 的应用发展。

在线体验

https://cloud.siliconflow.cn/models

第三方应用接入教程

https://docs.siliconflow.cn/cn/usercases/