在多模态嵌入学习领域,研究人员们不断努力将不同的数据形式连接在一起,以便更好地理解和处理多样化的信息。近期,由 Salesforce Research、加州大学圣巴巴拉分校、滑铁卢大学及清华大学的研究团队共同提出了 VLM2Vec-V2,这是一种全新的多模态嵌入学习框架,旨在统一图像、视频和视觉文档的检索任务。

现有的多模态嵌入模型通常训练于特定的数据集,如 MMEB 和 M-BEIR,主要集中在自然图像和照片上。这些数据集大多来自 MSCOCO、Flickr 和 ImageNet,未能涵盖更广泛的视觉信息类型,例如文档、PDF、网站、视频和幻灯片。这种局限性导致现有的嵌入模型在实际任务中的表现不尽人意,比如文章搜索、网站搜索以及 YouTube 视频搜索。

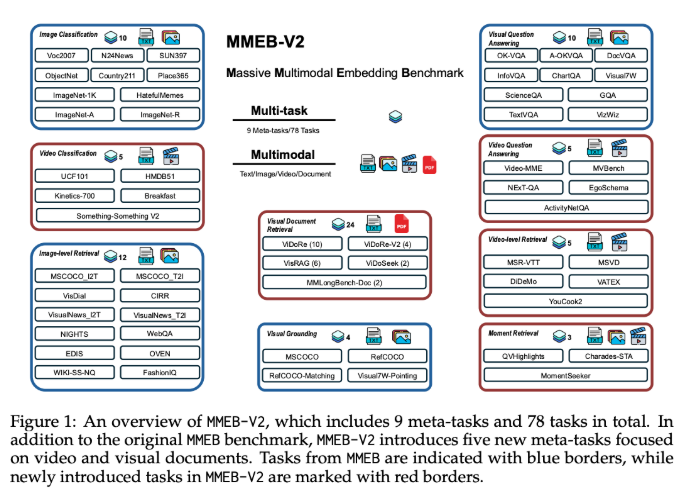

VLM2Vec-V2的推出,首先扩展了 MMEB 数据集,新增了五种任务类型,包括视觉文档检索、视频检索、时间定位、视频分类和视频问答。这一扩展为多模态学习提供了更丰富的评估标准。此外,VLM2Vec-V2作为通用的嵌入模型,支持多种输入形式,在新任务和传统图像基准测试上都表现出色,为研究和实际应用奠定了更灵活和可扩展的基础。

VLM2Vec-V2采用了 Qwen2-VL 作为其核心架构,后者在多模态处理方面具有独特的优势。Qwen2-VL 具备三大关键特性,分别是简单动态分辨率、多模态旋转位置嵌入(M-RoPE)以及结合二维和三维卷积的统一框架。为了实现跨多种数据源的有效多任务训练,VLM2Vec-V2还引入了一种灵活的数据采样管道,利用预设的采样权重表和交错的子批处理策略来提升对比学习的稳定性。

在综合78个数据集的评估中,VLM2Vec-V2以58.0的最高平均得分领先于多个强基线模型,并在图像任务和视频任务上展现出优异的表现。尽管在视觉文档检索方面略逊于 ColPali 模型,VLM2Vec-V2在多模态学习的统一框架上为未来的研究指明了方向。

项目:https://github.com/TIGER-AI-Lab/VLM2Vec

huggingface:https://huggingface.co/VLM2Vec/VLM2Vec-V2.0

划重点:

📊 VLM2Vec-V2是一个新推出的多模态嵌入学习框架,能够统一图像、视频和视觉文档的检索任务。

📝 新模型的评估数据集 MMEB-V2增加了多种任务类型,提升了多模态学习的丰富性和准确性。

🚀 VLM2Vec-V2在多个任务中表现优异,成为了多模态学习领域的重要基准模型。