在人工智能图像编辑与生成领域,一项新的突破性技术引起了广泛关注。字节跳动与香港中文大学、香港科技大学和香港大学联合研发的 DreamOmni2系统,已正式开源,标志着图像编辑生成技术的最新发展。

DreamOmni2的推出,致力于提升人工智能在图像处理中的指令遵循能力,实现了真正的多模态指令理解。这一系统能够同时理解文本指令与参考图像,显著改善了以往模型在处理抽象概念(如风格、材质、光照)时的局限性。用户与 AI 之间的交互更加自然,仿佛与一个了解自己意图的合作伙伴对话。

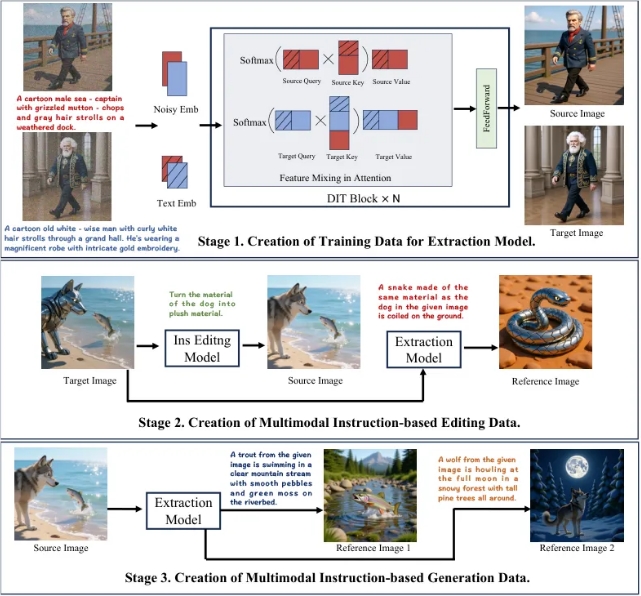

为了训练 AI 理解复杂的文本和图像指令,DreamOmni2的研发团队开发了一套创新的三阶段流程。首先,通过训练提取模型,AI 能够精准提取图像中的特定元素或抽象属性。接着,利用提取模型生成多模态指令编辑数据,形成包含源图像、指令、参考图像和目标图像的训练样本。最后,通过进一步提取与组合生成更多参考图像,构建出丰富的多模态指令生成数据集。这一系列步骤为系统的高质量训练打下了坚实基础。

在模型架构方面,DreamOmni2提出了索引编码和位置编码偏移方案,确保模型能够准确识别多张输入图像。同时,引入视觉语言模型(VLM),有效解决了用户指令与模型理解之间的鸿沟。这种创新设计提升了系统在处理指令时的准确性,使其能够更好地理解用户的真实意图。

经过测试,DreamOmni2在多模态指令编辑任务上的表现超越了所有参与比较的开源模型,接近顶尖商业模型。与传统的商业模型相比,DreamOmni2在处理复杂指令时,能够提供更高的准确性和一致性,避免了不必要的变更和图像瑕疵。

DreamOmni2的开源,不仅为 AI 创作提供了新的可能性,也为相关领域的研究者提供了统一的评判标准。这一技术的发布,预示着 AI 图像编辑与生成领域即将迎来新的革命。对于未来的发展,业内专家表示,DreamOmni2的成功将极大推动 AI 技术的普及和应用。