近日,英伟达研究团队发布了全新的 OmniVinci 全模态理解模型,该模型在多个全模态理解基准测试中,表现出色,超越了目前最顶尖的模型19.05分。更令人瞩目的是,OmniVinci 在训练过程中仅使用了0.2万亿的训练 Token,相较于竞争对手的1.2万亿,其数据效率是其六倍。

OmniVinci 的核心目标是打造一个可以同时理解视觉、音频和文本的人工智能系统,使机器能够像人类一样,通过不同感官感知和理解复杂的世界。为了实现这一目标,研究团队不仅仅是简单地增加数据量,而是通过创新的网络架构和数据管理策略,成功实现了性能和效率的双重提升。

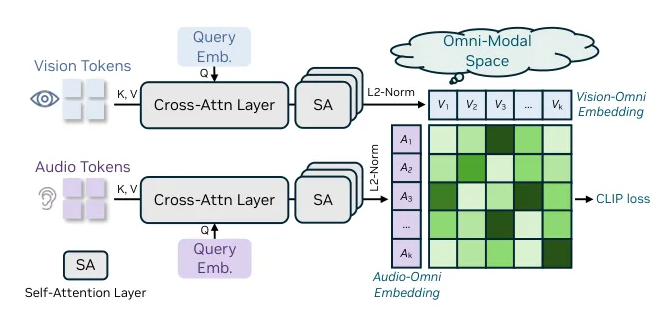

在设计上,OmniVinci 采用了全模态潜在空间的概念,旨在融合来自不同感官的信息,实现跨模态的理解与推理。研究团队发现,不同模态之间在感知和推理层面能够相互强化,这一发现为多模态 AI 系统的构建指明了方向。

OmniVinci 的架构设计具有可组合的跨模态理解能力,整合了图像、视频、音频和文本等异构输入。通过统一的全模态对齐机制,该模型能够将不同模态的嵌入信息整合到一个潜在空间中,进一步输入到大语言模型(LLM)中。该机制包括三项关键技术,其中 OmniAlignNet 模块有效对齐视觉和音频信息,而时间嵌入分组和约束旋转时间嵌入则提升了模型对时间信息的理解。

为了培养 OmniVinci 的全模态理解能力,研究团队采用了两阶段的训练方法。首先是模态特定训练,接着进行全模态联合训练,利用隐式和显式学习数据,显著提升了模型的联合理解能力。

随着 OmniVinci 的发布,英伟达再次展示了其在人工智能领域的技术创新,预示着未来 AI 系统将更加智能、灵活。

github:https://github.com/NVlabs/OmniVinci

划重点:

🌟 OmniVinci 模型在全模态理解基准测试中超越了顶尖模型19.05分。

📊 训练数据量仅为竞争对手的1/6,数据效率提升至六倍。

🔑 采用创新架构和两阶段训练方法,显著提升模型的多模态理解能力。